文章詳情頁

Python中使用超長的List導致內存占用過大

瀏覽:115日期:2022-06-26 15:00:47

問題描述

我需要在一段程序中使用一個長度超過50萬的List,但結果就是內存使用率瞬間升高

請問應該用什么方法進行優化?

問題解答

回答1:這個 list 一定要放在內存里嗎?

如果你是一條一條處理的,并不需要全在內存,你可以把這些內容先寫到磁盤文件,然后打開它,用類似下面的語句:

for item in file(’xxx.txt’).xreadlines(): ... # 解析出你的內容,并處理

相關文章:

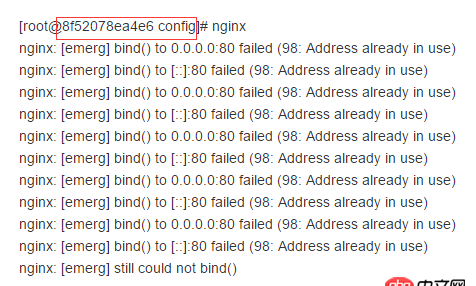

1. docker容器呢SSH為什么連不通呢?2. docker api 開發的端口怎么獲取?3. docker網絡端口映射,沒有方便點的操作方法么?4. 關docker hub上有些鏡像的tag被標記““This image has vulnerabilities””5. python - from ..xxxx import xxxx到底是什么意思呢?6. nignx - docker內nginx 80端口被占用7. debian - docker依賴的aufs-tools源碼哪里可以找到啊?8. javascript - 移動端,當出現遮罩層的時候,遮罩層里有div是超出高度scroll的,怎么避免滑動div的時候,body跟隨滑動?9. 請教各位大佬,瀏覽器點 提交實例為什么沒有反應10. ddos - apache日志很多其它網址,什么情況?

排行榜

網公網安備

網公網安備